현대의 대규모 언어 모델, 특히 OpenAI의 GPT-3.5와 GPT-4와 같은 모델들은 텍스트를 토큰이라는 문자의 시퀀스로 처리한다.

이러한 토큰화(Tokenization)는 텍스트를 분석하고 생성하는 데 중요한 역할을 한다.

이 글에서는 토큰화의 개념, 모델별 토큰화의 차이점, 그리고 토큰 규칙에 대해 살펴본다.

토큰화(Tokenization)란 무엇인가?

토큰화는 텍스트를 작은 단위인 토큰으로 분리하는 과정이다.

토큰은 일반적으로 단어, 부분 단어, 혹은 심볼 등의 문자 시퀀스다.

예를 들어, "ChatGPT는 훌륭해"라는 문장을 토큰화하면 ["Chat", "GPT", "는", "훌륭", "해"]와 같은 토큰 시퀀스로 변환될 수 있다. OpenAI의 언어 모델들은 이러한 토큰 간의 통계적 관계를 이해하여 시퀀스에서 다음 토큰을 예측하고 생성한다.

모델별 차이점

GPT-3.5와 GPT-4는 각각 다른 토크나이저를 사용한다.

이는 동일한 입력 텍스트에 대해 두 모델이 서로 다른 방식으로 토큰을 생성할 수 있음을 의미한다.

예컨대, GPT-3.5는 "ChatGPT"를 하나의 토큰으로 처리할 수 있지만, GPT-4는 이를 ["Chat", "GPT"]와 같이 두 개의 토큰으로 분리할 수 있다.

이러한 차이는 모델의 성능과 텍스트 처리 방식에 영향을 미친다.

토큰 규칙

일반적인 영어 텍스트의 경우, 한 토큰은 대략 4개의 문자에 해당한다.

이는 약 ¾ 단어에 해당하며, 100 토큰은 약 75 단어로 볼 수 있다.

따라서 긴 문장을 입력할 때는 토큰 수를 고려해야 한다.

토큰 수 계산의 중요성

토큰 수를 계산하는 것은 언어 모델을 효율적으로 사용하는 데 매우 중요하다.

토큰 수가 제한된 경우, 입력 텍스트를 적절하게 분할하고 조정하여 모델의 성능을 최적화할 수 있다.

GPT-4는 한 번에 최대 8,000개의 토큰을 처리할 수 있으므로, 이를 초과하는 입력 텍스트는 잘라내거나 요약해야 한다.

정리하면

토큰화는 OpenAI의 언어 모델이 텍스트를 이해하고 생성하는 데 필수적인 과정이다.

GPT-3.5와 GPT-4와 같은 모델은 각각 다른 토크나이저를 사용하여 입력 텍스트를 처리한다.

일반적인 영어 텍스트의 경우, 한 토큰은 약 4개의 문자에 해당하며, 이는 약 ¾ 단어에 해당한다.

최적의 답을 얻기 위해서는 토큰 수를 잘 관리하는 것이 중요하다.

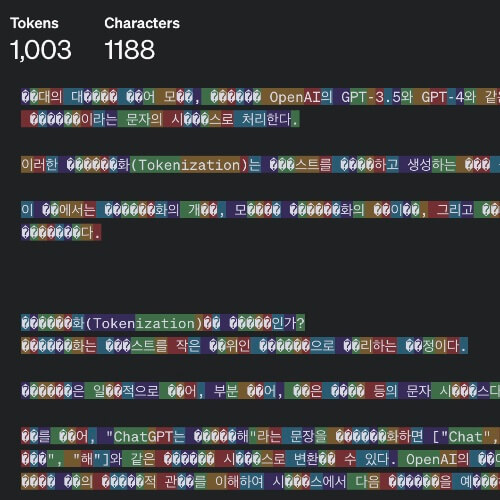

그래서 토큰 수는 어디서 세나?

아래 사이트를 참고하기 바란다.

https://platform.openai.com/tokenizer

'요점만 간단히' 카테고리의 다른 글

| 카카오톡 조용히 나가기 (0) | 2024.06.08 |

|---|---|

| 부동산 PF 위기 뜻 (0) | 2024.05.30 |

| 유튜브 추천 초기화 시청 기록 삭제 (0) | 2024.05.29 |

| 간이과세자 전환통지서 간이과세포기신고 (0) | 2024.05.28 |

| 설거지를 뜨거운 물로 해야 하는 이유 (0) | 2024.05.20 |

댓글